La grâce consiste, d’après ce que nous avons dit, en ce que chaque mouvement ou attitude se produit de la manière la plus facile, la plus mesurée, la plus aisée, et devient par là même l’expression parfaitement exacte de l’intention qui l’a dicté, c’est-à-dire de l’acte de volonté ; il ne faut rien de superflu ; le superflu se trahit par des gestes désordonnés et insignifiants, par des attitudes contournées ; rien d’incomplet non plus, sous peine de tomber dans la raideur. La grâce suppose une proportion rigoureuse de tous les membres, un corps régulièrement et harmonieusement bâti : telle en est la condition ; puisque c’est seulement à ce prix qu’on obtient l’aisance parfaite, l’harmonie évidente de tous les mouvements et de toutes les attitudes, il s’ensuit que la grâce ne peut exister sans un certain degré de beauté corporelle. Unissez la beauté et la grâce parfaites, vous aurez la manifestation la plus claire de la volonté au degré supérieur de son objectivation.

Arthur Schopenhauer, Le monde comme volonté et comme représentation

La beauté d’une race, d’une famille, sa grâce, sa perfection dans tous les gestes est acquise péniblement : elle est comme le génie, le résultat du travail accumulé des générations. Il faut avoir fait de grands sacrifices au bon goût, il faut à cause de lui avoir fait et abandonné bien des choses ; le dix-septième siècle, en France, mérite d’être admiré sous ce rapport, — on avait alors un principe d’élection pour la société, le milieu, le vêtement, les satisfactions sexuelles ; il fallut préférer la beauté à l’utilité, à l’habitude, à l’opinion, à la paresse. Règle supérieure : on ne doit pas « se laisser aller » même devant soi-même.

Friedrich Nietzsche, Crépuscule des idoles

Dans un article précédent, j’ai abordé la question de la nature humaine et conclus que, s’il n’existe pas à proprement parler de nature humaine, il existe néanmoins des travers inhérents à l’existence et une nécessité de définir des catégories dont une pour les humains. Mais si le monde est en changement permanent, est-ce que ce changement va vers une direction et suit des principes précis ?

La meilleure cosmologie actuelle est accélérationniste et désintégrationniste. Pour dire les choses de manière crue — et finalement insoutenable — l’expansion de l’univers s’accélère et s’éloigne.

Nick Land, Disintegration

Traité

Néoréactionnaire

Le premier livre de NIMH

Traité

Néoréactionnaire

Le premier livre de NIMH

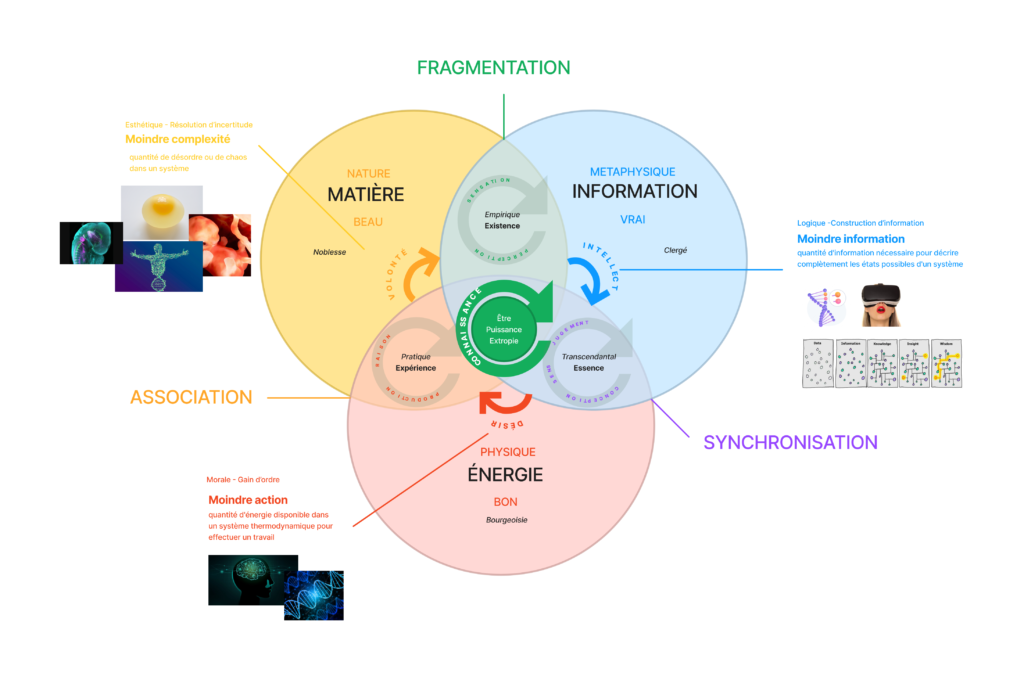

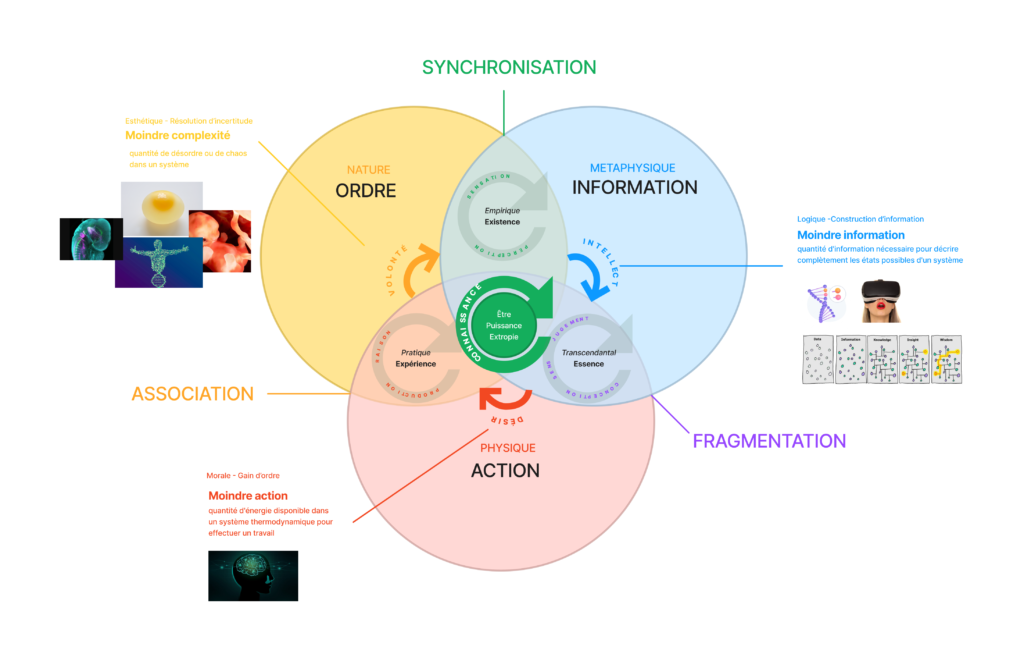

Il semble régner trois lois dans l’univers qu’on pourrait nommer la fragmentation, l’association et la synchronisation.

La fragmentation est liée à l’existence. Elle est l’expression de l’identité existant en essence, qui est, elle, une synchronisation au sein d’un tout. Mon identité est construite en relation à ce tout. Je suis un père, un fils, un empoloyé, un Français etc. Mon identité relève de cette synchronisation avec les autres systèmes. La fragmentation, elle, est l’expression d’une sécession, ou tout simplement l’expression d’une singularité au sein d’un tout qui va chercher sa voie propre. Elle est nécessairement potentiellement conflictuelle, car elle implique la séparation d’un système pré-existant. Lorsque des Anglais fuirent le royaume en quête de liberté vers le Nouveau Monde, le système lutta contre leur désir d’indépendance donc de libre association. Cette libre association est ce qui confère l’existence en germe à une entité préexistante au sein d’un système. Mais c’est par la fragmentation qu’elle parvient à l’existence. C’est seulement à la suite de la guerre d’indépendance que les États-Unis d’Amérique naîtront pleinement. Cette association permet alors de générer un nouveau système cohérent au sein duquel se dérouleront des échanges synchronisant les actes des entités le composant et le rendant ainsi fonctionnel. Les libertariens seraient d’ailleurs bien avisés de chercher le principe de non-agression dans cette nécessité. Mais ce nouveau système fera lui-même partie d’un environnement au sein duquel il sera en concurrence. La concurrence, résultera sur la fragmentation, et sera un principe fondamental pour assurer de nouvelles associations potentielles.

Cette fragmentation n’implique d’ailleurs pas nécessairement la disparition du système initiale et peut même être un moyen d’en améliorer le fonctionnement. Elle peut être la naissance d’une caste supérieure, d’une aristocratie qui va se distinguer du reste des entités du système tout en y appartenant pleinement, et même en le dirigeant. Elle va constituer une préférence d’association, une discrimination, permettant une meilleure synchronisation.

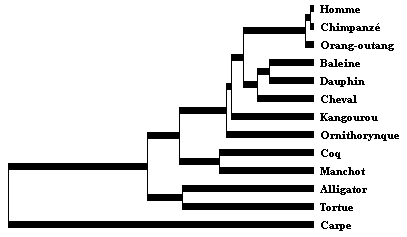

D’un point de vue darwinien, c’est ici le secret de la spéciation observé dans la phylogénèse. Chaque espèce constitue une fragmentation d’une espèce précédente qui avec le temps va donner des races différentes – sauf chez les humains qui sont une création à part de tout le reste du vivant ne formant qu’une seule race – qui finiront par donner des sous-espèces par le principe d’association et qui va participer à l’équilibre d’un éco-système où s’établira une synchronisation.

Cette association ne se fait pas au hasard. On observe par exemple que les descendances les plus fructueuses se trouvent dans l’association de deux organismes de sexe opposé – sauf chez les humains qui sont une espèce à part où ces règles ne s’appliquent pas – ni trop proches, ni trop éloignés. Et il semblerait que cette tension, visant à trouver un juste milieu le plus adéquat, se retrouve assez régulièrement dans l’univers. On appelle cela l’effet Goldilock en référence à Boucles d’or qui choisit toujours l’élément se trouvant au milieu. L’expression est utilisée pour décrire une situation où une condition considérée comme optimale, ou idéale, se situe quelque part entre deux extrêmes.

Prenez trois hommes français du même âge, 25 ans, et avec des capacités cognitives en tout point identiques, le même métier, les mêmes performances et le même salaire. Le premier mesure 1m60, le deuxième 1m75 et le troisième 1m90. Ils pratiquent tous une activité physique et ont la même IMC de 22. Ils pèsent alors respectivement 60kg, 75kg et 90kg. Ils ont donc un besoin journalier d’apport calorique de 1500, 1800 et 2100 calories. Lequel a le plus de chance de survivre et se reproduire ? Évidemment, pour réellement répondre à cette question il faudrait connaître beaucoup plus de paramètres que cela, mais je vais utiliser ces conditions initiales pour mener une réflexion.

En moyenne, les Français mesurent 1m75 donc le premier est en dessous de la moyenne, le deuxième est dans la moyenne et le troisième au-dessus. Dans les conditions actuelles, leurs chances de survie sont similaires, personne ne meurt de faim en France aujourd’hui. Cependant, le plus grand aura sans doute besoin de dépenser plus d’argent non seulement pour sa nourriture, mais aussi pour toutes les choses de la vie quotidienne comme les vêtements. Son organisme a besoin d’énergie et l’argent est de l’information. Son organisme a alors besoin de plus d’énergie et d’information pour les mêmes performances, le même salaire. Il est donc plus complexe. Dans un monde civilisé où la violence est interdite, le plus petit est en fait le plus optimisé.

Mais imaginons qu’il y ait une rupture suite à un effondrement et qu’il est plus difficile de trouver à se nourrir. Par exemple, les écolos prennent finalement le pouvoir. Celui qui a besoin de moins d’énergie pourra faire face plus facilement à une réduction des ressources, celui qui est plus grand dispose d’une force physique lui permettant potentiellement de se procurer plus de ressources illégalement au prix de certains efforts. Comment s’assurer que l’effort fourni est le plus faible et le moins risqué possible ? Attaquer l’individu d’1m60 plutôt que celui d’1m75.

Lequel une femme aura tendance à choisir pour se reproduire ? Celui qui est le plus adaptable dans un environnement changeant, donc le plus à même d’être synchronisé avec l’environnement, celui d’1m85. Ce que je dis ici a bien entendu plus valeur d’illustration que de présentation scientifique.

Dans un contexte plus général, l’effet Goldilocks peut être appliqué à divers domaines, tels que la biologie, la physique, la finance, l’écologie, la politique, etc. Par exemple, la zone habitable d’une planète est considérée comme ayant des conditions idéales pour la vie si elle est ni trop proche ni trop éloignée de son étoile hôte, mais juste à la bonne distance pour permettre l’existence d’eau liquide. L’homéostasie répond aussi à ce principe. La nécessité de l’existence maîtrisée d’inégalités pour le bon fonctionnement de la société, et de toute structure dissipative, que j’ai déjà exposé, répond aussi à ce principe. Il n’est alors pas étonnant d’observer une courbe en cloche pour tout un tas de données statistiques. Cependant, on aurait tort d’y voir ici un équilibre statique. Ce qu’on observe est un processus de perfectionnement. Tout élément ordonné est une structure dissipative en évolution échangeant de l’énergie et de l’information avec son environnement et je crois qu’elle répond à trois principes qui sont les principes de moindre action, moindre information et moindre complexité.

Je vous ai déjà parlé du principe de moindre action. Le principe de moindre action est un concept en physique qui stipule que le mouvement d’un système physique est tel que la quantité d’action totale du système est minimale. En d’autres termes, le système cherche à minimiser son action totale en suivant une trajectoire qui est appelée « trajectoire d’action minimale ». Cette idée est utilisée pour expliquer le mouvement de particules et de systèmes plus complexes en physique classique et en physique quantique.

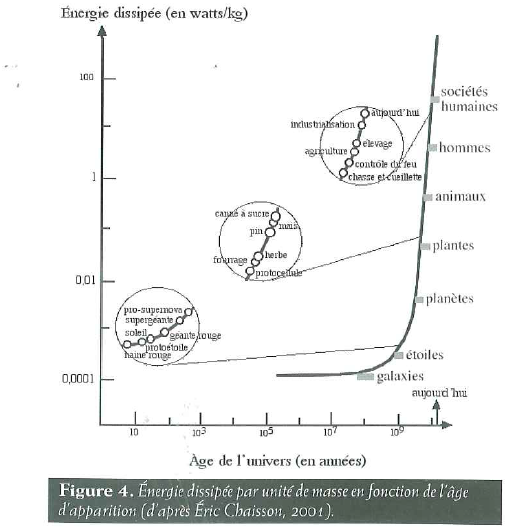

Le premier à avoir formulé l’idée que la nature obéit à un principe d’économie fut Leibniz, en 1690, qui parla de « Principe de moindre de dépense » et l’a utilisé pour décrire les lois de la mécanique. Mais c’est Maupertuis qui lui donnera le premier une dimension mathématique en 1744. Conclusion, la nature va chercher à optimiser la dissipation d’énergie donc, à maximiser l’action par unité d’énergie. C’est ainsi que l’évolution va favoriser l’émergence d’organismes de plus en plus complexes et de plus en plus intelligents afin de remplir ce but.

Si le principe de moindre action est alors une notion scientifique bien formulée, j’aimerais modestement introduire deux autres termes visant l’économie qui me semblent directement liés à ce processus qui sont le principe de moindre information et le principe de moindre complexité.

Comment sont-ils liés ? Par l’entropie. Pour ceux n’étant pas familiers avec les idées que j’ai développé par le passé, je vais expliquer très brièvement pourquoi je dis cela. L’entropie est une notion complexe qui renvoie tout à la fois à une mesure de dissipation d’énergie, d’ordre et d’information. Comme le formulera Georgescu-Roegen, elle est une mesure de l’inutilisabilité de l’énergie libre disponible pour produire un travail mécanique, donc une action. Mais elle est également une mesure de l’état d’incertitude. Incertitude qui appelle à être résolue par la génération d’information. Enfin, et comme elle fut communément admise en premier lieu, elle est une mesure de l’ordre d’un système, donc de sa complexité.

La complexité est une mesure de l’interaction, de l’interconnexion, de l’interdépendance et de l’adaptabilité des éléments au sein d’un système. En d’autres termes, plus un système a de composants qui interagissent de différentes manières, plus il est considéré comme complexe.

Un système complexe a souvent les caractéristiques suivantes :

- Non-linéarité : cela signifie que de petites modifications des conditions initiales ou des paramètres peuvent conduire à des différences significatives dans le comportement du système.

- Émergence : les propriétés émergentes sont des caractéristiques du système global qui ne peuvent pas être prédites simplement à partir de la connaissance des parties individuelles du système.

- Adaptabilité : les systèmes complexes ont souvent la capacité de s’adapter et de changer en réponse à leur environnement.

- Redondance et diversité : les systèmes complexes ont souvent de la redondance et de la diversité dans leurs éléments et leurs connexions, ce qui peut leur permettre de résister à des perturbations.

- Auto-organisation : c’est la capacité d’un système à se structurer ou à évoluer sans intervention extérieure.

Horreur

Augmentée

Sélection de textes de

Zero HP Lovecraft

Horreur

Augmentée

Sélection de textes de

Zero HP Lovecraft

L’information va alors être la quantité d’information nécessaire permettant le codage de la complexité d’un système. En plus de l’information, la complexité est au cœur de la cybernétique. Henri Atlan a, avec raison, proposé de décrire la complexité par la fonction H de la théorie de l’information de Shannon, c’est-à-dire comme le degré d’information qui manque encore pour décrire complètement le système.

La fonction H, dans la théorie de l’information, est la fonction d’entropie. Elle mesure la quantité d’incertitude ou d’imprévisibilité dans une source de données ou un ensemble de données. Plus précisément, la fonction d’entropie calcule le nombre moyen de bits nécessaires pour représenter chaque symbole dans une source de données ou un ensemble de données. On peut réduire la quantité d’information en la compressant sans en perdre la qualité et le sens jusqu’à un certain point. Par ce procédé, on va chercher à réduire la complexité du système tout en conservant sa fonctionnalité.

En d’autres termes, un système est complexe non seulement s’il a de nombreuses parties interconnectées, mais aussi s’il est difficile de prédire comment ces parties vont interagir. Selon Atlan, un système est d’autant plus complexe que son entropie (ou fonction H) est grande. Cela signifie que plus il est difficile de prédire l’état d’un système, plus ce système est complexe. Cela s’applique à de nombreux domaines, comme la biologie, où la complexité des organismes vivants peut être liée à l’incertitude inhérente à leurs processus biologiques, ou à la cybernétique, où la complexité d’un système informatique peut être liée à l’incertitude de ses processus de traitement de l’information.

Dans le contexte de la théorie de l’information, l’entropie est souvent considérée comme une mesure de la quantité d’information contenue dans une source de données ou un ensemble de données. Plus l’entropie est élevée, plus la source de données ou l’ensemble de données est imprévisible ou aléatoire, et donc plus il contient d’informations potentielles. Cela doit faire écho avec ce que nous avons énoncé au cours de notre réflexion sur l’Être que j’ai proposé de voir comme une totalité d’information potentielle bornée. Comme le dit Luhmann, « la complexité est l’unité d’une multiplicité ». Une structure est composée de ses parties, mais le tout est supérieur à la somme de ses parties, et ce tout va chercher à augmenter sa puissance tout en maintenant le nombre d’éléments nécessaires à l’optimisation de cette puissance le plus bas possible.

Comment se fait-il que l’entropie puisse mesurer à la fois la quantité d’énergie, d’information et le degré d’ordre ? Il faut comprendre comment ces trois choses sont entremêlées et s’influencent l’une l’autre. Pour cela, je vous propose le schéma ci-dessous.

À l’origine, dans le domaine de l’automobile, la longueur des moteurs, nécessitant une dimension correspondante du capot, était signe en même temps de puissance pour la machine, et de prestige social, pour l’homme. Mais le moteur, avec la disposition des cylindres en V, remplaçant la disposition en ligne, puis avec les soupapes en tête et l’augmentation du taux de compression et du régime de rotation, a pu augmenter sa puissance tout en réduisant son volume et sa masse.

Gilbert Simondon, Sur la technique

Il faut bien comprendre que ces choses sont interconnectées au sein d’un système dans un devenir qui a pour but la recherche de la réduction de son entropie ou, pour le dire autrement, l’augmentation de sa puissance. Mais il se loge au cœur de ce processus un paradoxe identifié par Léon Brillouin, physicien français qui a travaillé dans divers domaines, dont la physique quantique et la théorie de l’information. Le paradoxe de Brillouin est une réflexion importante sur la manière dont nous comprenons l’information dans le contexte de la physique thermodynamique et de la théorie de l’information. Tel qu’il est généralement compris, c’est une réfutation de la « valeur de l’information ». Selon lui, l’acquisition d’information nécessite nécessairement une dépense d’énergie, ce qui suggère que l’information n’est pas simplement une abstraction, mais a un coût physique tangible.

En termes plus techniques, Brillouin a montré que dans un système physique, l’obtention d’information pour réduire l’entropie (le désordre) du système nécessite un minimum de travail qui est déterminé par la relation de Planck (où k est la constante de Boltzmann, T est la température et ln(2) est le logarithme naturel de 2). Ce travail minimum est souvent appelé « le coût énergétique de l’information » ou « le coût de l’information de Brillouin ».

Ainsi, le paradoxe de Brillouin soulève des questions fondamentales sur la nature de l’information et ses interactions avec le monde physique, y compris le fait que l’obtention d’information n’est pas un processus « gratuit », mais implique des coûts énergétiques qui peuvent avoir des implications importantes en thermodynamique et en théorie de l’information. En mettant l’accent sur le coût énergétique de l’information, il souligne comment la complexité d’un système est liée à l’information nécessaire pour le décrire et le manipuler.

Dans le contexte de la théorie de l’information, la complexité d’un système peut souvent être associée à la quantité d’information nécessaire pour décrire ce système. Un système plus complexe nécessite généralement plus d’informations pour être pleinement décrit. Cela signifie qu’il y a un coût énergétique plus élevé pour obtenir l’information nécessaire pour comprendre et manipuler un système plus complexe. À mesure que les systèmes deviennent plus complexes, les coûts énergétiques associés à leur fonctionnement augmentent, ce qui peut devenir un facteur limitant dans le développement de technologies plus avancées.

De même, en biologie, l’information est stockée et manipulée sous forme d’ADN, et il existe un coût énergétique associé à la réplication de cette information lors de la division cellulaire. Ainsi, la complexité d’un organisme peut également être liée à l’énergie nécessaire pour maintenir et reproduire son information génétique. Le paradoxe de Brillouin met alors en évidence une contrainte fondamentale sur la complexité des systèmes, qui est intrinsèquement liée à la quantité d’information qu’ils contiennent et au coût énergétique associé à la manipulation de cette information.

Autrement dit, l’acquisition d’information va naturellement augmenter la complexité du système qui devra alors utiliser plus d’énergie pour maintenir l’information dudit système. Il va alors y avoir une nécessité à filtrer l’information pour ne conserver que celle qui est capitale, mais aussi d’optimiser la façon d’encoder cette information afin d’en réduire sa complexité. Cela aura pour finalité de produire des entités optimisant l’énergie dépensée.

Si vous pouviez voir l’histoire de l’homme en accéléré partant du Big Bang, vous verriez un monde en mouvement et en changement perpétuel, se recomposant infiniment à la façon des métamorphoses d’Ovide. Mais ces changements ne sont pas anarchiques et sans raison, ils se font suivant l’information produite par ces nouvelles entités et leur efficacité à dissiper l’énergie. Vous verriez la marche vers la complexité qui voit la mort d’étoiles donner naissance à l’homme qui est une entité capable de dissiper 10,000 fois plus d’énergie à masse égale.

Adaptation de la nouvelle de

Lovecraft en animation grâce

à l’IA

Adaptation de la nouvelle de

Lovecraft en animation

Les principes de moindre action, moindre complexité et moindre information sont alors ce qui va conduire, par exemple, à la naissance de l’homme en partant des étoiles. Moindre ne veut pas dire une diminution de ces trois choses, bien au contraire. L’information, l’ordre et l’énergie dissipée augmentent, mais cette augmentation s’accompagne d’une optimisation visant à éliminer le superflu.

Quoi qu’il en soit, et pour nous en tenir à l’idée même de la « simplicité primitive », on ne comprend pas du tout pourquoi les choses devraient toujours commencer par être simples et aller ensuite en se compliquant ; au contraire, si l’on réfléchit que le germe d’un être quelconque doit nécessairement contenir la virtualité de tout ce que cet être sera par la suite, c’est-à-dire que toutes les possibilités qui se développeront au cours de son existence y sont déjà incluses, on est amené à penser que l’origine de toutes choses doit en réalité être extrêmement complexe et c’est là, précisément, la complexité qualitative de l’essence ; le germe n’est petit que sous le rapport de la quantité ou de la substance, et en transposant symboliquement l’idée de « grandeur », on peut dire que, en raison de l’analogie inverse, ce qui est le plus petit en quantité doit être le plus grand en qualité.

René Guénon, Le Règne de la Quantité et les Signes des Temps

Cela est peut-être un peu trop ésotérique à ce stade alors prenons un exemple concret à appliquer à ce schéma pour expliciter ce que je nomme les principes de moindre action, moindre information et moindre complexité.

Imaginez un écrivain qui va se lancer dans l’écriture d’une narration. Il connaît le point de vue qu’il veut défendre dans son ouvrage, mais il est face à une page blanche. Il peut choisir n’importe quelle époque, n’importe quels personnages, n’importe quelle intrigue et situation. Sa page blanche est simple, mais son esprit contient lui toutes les possibilités qui rendent le récit potentiel en même temps extrêmement complexe. Il va alors s’engager un processus de va-et-vient entre la pensée de l’écrivain qui va considérer les possibilités qui s’offrent à lui et l’écriture sur la page blanche des options sélectionnées. Va-t-il considérer toutes les possibilités ? Bien sûr que non, il lui faudrait plus d’une vie. Il est limité par le temps et l’énergie qu’il peut y consacrer donc il va en considérer quelques-unes seulement et choisir celles qui lui semblent les plus opportunes. Ces possibilités existent virtuellement, mais seules quelques-unes vont être couchées sur le papier et devenir actuelles.

Les lignes d’écritures vont constituer la partie manifestée d’un ensemble plus large. Ces actualités vont alors conditionner le choix des autres possibilités à venir. Au fur et à mesure de l’écriture, notre écrivain va venir ajouter, puis retirer les informations dont il a besoin pour mettre en avant son point de vue de la façon la plus élégante donc la plus logique et esthétique. Sur la forme, sa page blanche initiale va paraître de plus en plus complexe, pourtant cette complexité en apparence repose sur une sélection de possibilités plus large.

La recherche de moindre information va augmenter la complexité formelle. Mais au fur et à mesure, l’auteur va revenir sur ses écrits, les retravailler, les simplifier et réduire ainsi leur complexité. Jusqu’au moment où il estimera qu’il a une version qu’il peut soumettre à la lecture d’un tiers afin d’avoir son retour. Ce retour sera une nouvelle information précieuse pour l’auteur afin de savoir ce qui doit être modifié et commencer un nouveau processus qui se répétera jusqu’à ce qu’il obtienne un manuscrit narrant un récit mettant son point de vue en avant où rien n’est superflu.

Son manuscrit constitue alors le Blueprint d’un travail d’impression qui fera office de réplicateur de cette information. En retirant tout le superflu selon les principes de moindre information et moindre complexité, notre auteur réduira l’énergie et la matière nécessaire à l’impression de son livre, et par là même, le prix de ce dernier, lui offrant plus de chance de viralité.

Il est ainsi passé d’un état d’une complexité maximale contenant toute l’information possible en puissance, mais inexistant dans le monde matériel, à un produit fini dans le monde matériel contenant juste ce qu’il faut d’information sélectionnée pour optimiser la transmission de son message via un artefact physique. Son but sera alors la recherche de perfection dans le produit délivrant la connaissance adéquate sans saturer le lecteur d’information inutile. Ce degré de perfection est la beauté dont il recèle. Et cela marche pour tous les processus créatifs, y compris la sélection naturelle et les systèmes d’organisation politique, comme nous le verrons dans le prochain article.