Cet article fait suite à celui intitulé : Morale Aristo-Archiloquienne, la vie au service de l’information et l’être, en tant que complément à ce dernier et en préambule au prochain article de la série qui définira une vision du monde prométhéenne. Il est recommandé de lire la suite d’articles dans l’ordre mais je choisis cependant de mettre cet article en dehors de la série car nous touchons ici à des sujets pour lesquels il n’y a pas de certitudes.

Il est plus probable que le monde matriciel, celui qui contient le véritable noyau de l’être, soit déterminé par le programmeur. C’est lui qui articule – imprime, pour ainsi dire – le choix matriciel et le fusionne avec la substance réelle. Le noyau ou l’essence de la réalité – ce qui la reçoit ou l’atteint et à quel degré – est du ressort du programmeur ; cette sélection et resélection font partie de la créativité générale, de la construction du monde, qui semble être sa tâche. Un problème, peut-être, qu’il est en train d’exécuter, c’est-à-dire de résoudre.

Philipp K Dick, Conférence de Metz, 1977

Nous avons mis en avant dans l’article précédent l’importance de l’information qui peut être vue comme une propriété fondamentale du cosmos. Cela pose une question importante : est-ce l’information qui est au service de la dissipation d’énergie ou la dissipation d’énergie qui est au service de l’information ? Le corollaire étant : Est-ce la matière qui est au service de l’esprit ou l’esprit au service de la matière ? La réponse à cette question est fondamentale, car si on donne la primauté à la dissipation d’énergie alors le réalisme et le matérialisme ont tout leur sens, mais si on admet que le plus important est l’information alors l’idéalisme semble tout aussi acceptable que le réalisme dans cette situation.

Pensez aux captchas où on vous demande de sélectionner tous les feux tricolores sur une image. Est-ce que le plus important est votre capacité à sélectionner les bonnes images ou l’algorithme qui apprend grâce à l’information que vous participez à créer en partageant votre propre connaissance ? De votre point de vue, c’est votre capacité à choisir les bonnes images car cela va vous permettre de passer une étape ; mais du point de vue du créateur de l’algorithme, c’est l’information que vous générez. De la même façon, est-ce que le plus important est l’univers que vous participez à organiser en dissipant de l’énergie ou l’information que vous générez au cours de ce processus ? Est-ce qu’on vit dans un captcha géant, une simulation, où la primauté revient à l’information qu’on génère qui existe sur un autre plan que ce qu’on tient pour la réalité matérielle ?

Traité

Néoréactionnaire

Le premier livre de NIMH

Traité

Néoréactionnaire

Le premier livre de NIMH

Vivons-nous dans la réalité ?

J’évoquais la Redpill dans un article précédent. Nous la retrouvons ici dans son sens premier du terme telle qu’elle est utilisée dans Matrix. Vivons-nous dans la réalité ? Une question qu’on se pose au moins depuis Platon avec son allégorie de la caverne et qu’on retrouve sous la plume de Descartes qui se demande si le monde existe ou s’il ne serait pas trompé par un démon.

Aujourd’hui, Elon Musk, en s’appuyant sur une réflexion de Nick Bostrom, la remet au goût du jour en affirmant qu’il y a une chance sur un milliard que nous vivions dans la réalité et non dans une simulation. Le monde que l’on tient pour la réalité ne le serait pas. Mais cela part d’une intuition inférée par la raison. Le raisonnement de Musk est le suivant : ayant été capables de passer de Pong dans les années 80 à des metaverses proches de la réalité aujourd’hui, nous arriverons à créer des univers virtuels en tout point similaires au nôtre. Mais si nous sommes capables de le faire alors les chances qu’une civilisation l’ait fait avant nous est extrêmement haute et les chances que nous vivions dans une de ces simulations est presque de 100%.

Ce que l’on appelle “réalité” relèverait en fait du virtuel et la conscience précèderait l’existence. La matière ne serait qu’un phénomène généré par des bits. La réalité virtuelle pourrait même être imbriquée dans une chaîne de mondes virtuels jusqu’à atteindre la “vraie” réalité et le créateur initial, un démiurge qui serait de fait un hacker dans le monde supérieur. Vous pensez que cette hypothèse est farfelue ? Vous l’ignorez peut-être mais le réalisme est mis à mal depuis les découvertes liées à la mécanique quantique.

Pourquoi le réalisme est-il mis à mal par la mécanique quantique ? car il remet en question notre capacité à répondre à deux questions fondamentales nécessaires pour affirmer un réalisme. Ces deux questions, Lee Smolin les a remarquablement formulées dans son ouvrage La révolution inachevée d’Einstein :

Première question – Le monde naturel existe-t-il indépendamment de notre esprit ? Plus précisément, la matière possède-t-elle des propriétés en soi, indépendamment de ce que nous pouvons en percevoir et connaître ?

Lee Smolin

Deuxième question – Avons-nous la capacité de comprendre et de décrire ces propriétés ? Pouvons-nous appréhender suffisamment les lois de la nature pour expliquer l’histoire de notre Univers et prédire son avenir ?

Lee Smolin

Ceux qui répondent oui à ces deux questions sont les réalistes. À l’inverse, les antiréalistes, qui répondent non à l’une ou l’autre (ou les deux) de ces questions, vont s’opposer à ce mode de pensée. Mais pourquoi des personnes censées répondraient non à ces deux questions ? Pour cela il faut comprendre comment la mécanique quantique a mis au défi notre vision du monde, notre capacité à générer des connaissances sur ce dernier et nous a fait basculé d’un monde déterministe à un monde probabiliste.

Einstein le réaliste vs Bohr l’antiréaliste et la mécanique quantique

Laissez-moi vous conter l’histoire de la physique quantique de façon aussi partielle que rapide. Einstein, après avoir révolutionné notre perception du monde via la théorie de la relativité générale, est celui qui, et peu de gens le savent, a aussi introduit la physique quantique en proposant en 1905 la nature double de la lumière qui est à la fois particule, ou corpuscule, et onde. Cela fut confirmé en 1921 et il reçut le prix Nobel pour cette découverte. Louis de Broglie mis alors en avant que ce n’était pas seulement la lumière mais toute particule qui était aussi une onde.

À partir des travaux de Broglie, Schrödinger a alors développé une équation qui décrit l’évolution dans le temps d’une particule. Mais si Einstein fut l’initiateur de la physique quantique et que de Broglie et Schrödinger étaient des réalistes comme lui, elle lui a échappé et s’est dirigée vers des rives antiréalistes qui peinaient à le convaincre. Celui qui devint la figure de proue de cette révolution quantique fut son ami Niels Bohr, un antiréaliste dur avec qui il partageait une ferme différence de point de vue philosophique.

“La mécanique quantique est sans nul doute impressionnante. Mais une voix intérieure me souffle que ce n’est pas encore la réalité. La théorie nous dit beaucoup, mais ne nous rapproche pas vraiment du secret “du Vieux”. Je suis en tout cas convaincu qu’Il ne joue pas aux dés. ”

Albert Einstein

Alors qu’Einstein s’accrochait à une recherche d’une description complète du monde microscopique des atomes, des électrons et de la lumière, Bohr pensait, lui, que la physique atomique exigeait une révolution radicale de notre conception de la science, de notre rapport à la réalité et de notre capacité à la connaître. Pourquoi la vision de Bohr s’est imposée ? Je l’ignore. Peut-être parce qu’on aime les révolutions, peut-être que le danger du communisme matérialiste a aidé à soutenir une vision s’opposant au réalisme ou peut-être tout simplement que Bohr avait raison.

Ce qu’il faut comprendre c’est que la mécanique quantique nous dit qu’on ne peut pas connaître toute l’information dont nous aurions besoin afin de prédire avec précision l’avenir. Contrairement à ce qu’on appelle “l’état classique” qui se réfère à la physique classique et suppose qu’on dispose de la totalité de l’information nécessaire permettant de prédire son avenir, l’état quantique démontre l’impasse de cette vision puisqu’il met en avant que, une particule de matière étant aussi dans le même temps une onde, on ne peut avoir que la moitié de cette information à la fois lorsqu’on l’observe et le mesure.

On ne peut pas connaître en même temps avec exactitude la position et la vitesse d’une particule. On ne peut mesurer qu’une seule propriété à la fois et si on souhaite les mesurer indépendamment l’une après l’autre notre propre observation fait changer la mesure de la première propriété lorsqu’on mesure la seconde. Et plus on cherche à exprimer une valeur de façon précise, plus l’autre devient imprécise. La mécanique quantique appelle donc à répondre “Non” à la seconde question formulée par Lee Smolin.

C’est ce qu’on appelle le principe d’indétermination quantique qui dit que le résultat d’une mesure ne peut être prédit que de manière probabiliste. On considère aussi qu’une particule peut être dans plusieurs états à la fois. Un électron qui tourne autour d’un atome peut être sur tous les points de l’orbite en même temps, et à toutes ses vitesses possibles. C’est la superposition des états. Mais la mesure modifie l’état quantique du système mesuré : il devient l’état précis correspondant au résultat de la mesure. C’est ce qu’on appelle l’effondrement de la fonction d’onde. Et comme si cela ne suffisait pas, deux particules peuvent former un système lié. Quand l’une bouge, l’autre aussi, et cela quelle que soit la distance entre les deux. C’est ce qu’on appelle l’intrication quantique.

On obtient alors les deux règles fondamentales de la mécanique quantique :

Règle 1 – l’équation de Schrödinger : Étant donné l’état quantique d’un système isolé à un moment donné, il existe une loi qui prévoit l’état quantique précis de ce système à n’importe quel autre moment.

Règle 2 – Le résultat d’une mesure ne peut être prédit que de manière probabiliste. Mais la mesure modifie l’état quantique du système mesuré : il devient l’état précis correspondant au résultat de la mesure. C’est ce qu’on appelle l’effondrement de la fonction d’onde.

Bohr va alors tirer une conclusion radicale de ces lois. En tant qu’observateur on agit sur la connaissance qu’on cherche à produire car nous faisons nous-mêmes partie du monde et, étant obligés d’interagir avec les atomes qu’on cherche à décrire, on ne fait que mesurer une information résultant de l’interaction entre l’atome et nos machines. La mesure effectuée de cet état quantique ne serait alors pas la réalité physique de cette particule mais simplement la connaissance de notre interaction avec elle. Ainsi, nous devrions aussi répondre “Non” à la première question.

On peut alors diviser les gens en deux catégories. Une première catégorie regroupant ceux qui pensent que la mécanique quantique est parfaitement valide, comme Niels Bohr et Heisenberg, qu’on nommera les antiréalistes, mais aussi des réalistes, qu’on nommera réalistes magiques, qui vont cravacher pour essayer de faire tenir des théories réalistes compatibles ; et une deuxième catégorie regroupant ceux qui pensent que cette théorie est incomplète comme Einstein, de Broglie, Schrödinger et Smolin qu’on appellera les réalistes naïfs qui souhaitent trouver une solution non alambiquée.

Les antiréalistes

Les tenants de la position antiréaliste, tels que Niels Bohr, mais aussi ses élèves Heinsenberg et Wheeler, sont ceux qui ont eu le plus d’influence. Niels Bohr fut le plus influent d’entre eux et devint le mentor de toute une génération de scientifiques qui ont défini notre façon d’appréhender la physique quantique.

Lee Smolin classe les antiréalistes en trois catégories :

- 1) les antiréalistes radicaux comme Niels Bohr qui pensent que les propriétés attribuées aux particules ne sont pas inhérentes à ces objets et n’existent que dès lors qu’on les mesure car créées par notre interaction avec elles. C’est la version la plus communément acceptée du “sens” de la mécanique quantique donnée lors de la conférence de Copenhague tenue par Bohr à la fin des années 1920. Elle soutient que nous ne pouvons pas spécifier la nature de la réalité fondamentale. Les entités subatomiques existent dans les limbes probabilistes de nombreux états possibles “superposés” jusqu’à ce qu’elles soient mises en évidence par l’acte de mesure. Les antiréalistes radicaux répondent donc non aux deux questions.

- 2) Les antiréalistes épistémologiques qui pensent que la science ne parle pas de ce qui est réel dans la nature mais de notre connaissance sur cette dernière. Le monde existe indépendamment du fait qu’on l’observe ou non, l’information existe, mais nous serions incapables de l’obtenir par l’observation. S’il y a quelque chose à connaître sur les atomes, nos méthodes de production de la connaissance souffrent d’un problème puisque nous ne pouvons seulement le comprendre dans ses interactions et lorsque nous l’observons nous faisons partie intégrante de cette interaction et donc nous ne pouvons qu’obtenir la connaissance de notre interaction avec l’atome et non de l’atome en lui-même. L’atome existerait bien en soi mais cette connaissance nous serait inaccessible. il y aurait donc plus à connaître lorsque nous ne l’observons pas mais on ne peut pas le connaître sans l’observer. Pour imager cela, imaginez que vous êtes face à un ami qui semble pensif, vous n’avez aucune façon de savoir à quoi il pense et si vous lui demandez “À quoi tu penses ?” alors à ce moment précis il se met à penser à votre question et sa réponse sera “Je pense à ta question”. Et vous ne pourrez jamais savoir à quoi il pensait. D’où la supériorité qu’Aristote donne à la philosophie qui serait la seule façon de tenter de comprendre les choses de façon ontologique, au-delà de l’observation. Car l’observation ne nous permet pas d’obtenir toute l’information donc de connaître pleinement l’être d’une particule.

- 3) Les antiréalistes opérationnalistes, dont Heisenberg fait partie dans une certaine mesure, qui sont agnostiques quant à l’existence ou non d’une réalité fondamentale indépendante de nous mais pensent aussi que la mécanique quantique ne peut permettre de comprendre ce qu’est un atome en soi mais seulement ce qui se passe lorsqu’ils entrent en contact avec nos appareils de mesure.

Horreur

Augmentée

Sélection de textes de

Zero HP Lovecraft

Horreur

Augmentée

Sélection de textes de

Zero HP Lovecraft

Les théories réalistes alternatives

Pourquoi la mécanique quantique marche au niveau micro mais pas au niveau macro ? La mécanique quantique défie notre bon sens. Elle devrait être valable universellement, or si on observe qu’elle marche sur des particules et, même sur des molécules, on est d’accord pour dire qu’un chat est soit vivant soit mort et non les deux à la fois et que s’il est à Paris il ne peut pas être à Berlin en même temps. Lorsque vous partez travailler le matin en laissant votre chaise à un endroit, vous ne vous attendez pas à potentiellement la retrouver chez le voisin en fonction de votre observation le soir.

Un réaliste se demandera si l’état quantique représente quelque chose de réel. Lee Smolin, marchant dans les pas d’Einstein et soucieux de sauver le réalisme, aboutit alors aux questions suivantes : L’état quantique d’une particule correspond-il précisément à la réalité physique de cette particule ? Ou bien constitue-t-il seulement un outil pratique pour faire des prédictions ? Peut-être ne décrit-il pas la particule, mais seulement l’information que nous avons sur elle ? En d’autres termes, est-ce qu’une particule est réellement à différentes positions et différentes vitesses en même temps jusqu’à ce qu’on l’observe ? Cela relève-t-il seulement de l’information probabilistique dont nous disposons sur elle ? Cela relève-t-il seulement du au fait que ce soit à la fois une onde et une particule ? Mais la vraie question sous-jacente est : est-ce que la mécanique quantique est une théorie viable ou appelle-t-elle à être remplacée radicalement ?

Il existe alors des théories alternatives à la mécanique quantique qui furent proposées très tôt et qui s’accordent avec une vision du monde réaliste. Elles souffrent cependant toutes de lacunes mais à leur corps défendant, elles furent délibérément ignorées pour certaines ce qui empêcha les chercheurs de se pencher dessus dans le but de les consolider. Lee Smolin en fait le tour et je vais vous les présenter succinctement ici.

Théorie de l’onde pilote de Broglie-Bohm

La première est nommée théorie de l’onde pilote, et fut défendue par Louis de Broglie dès 1927. Elle fut totalement passée sous silence, avant que David Bohm ne la reprenne à son compte en 1952 pour en faire la théorie qu’on connait sous le nom de théorie de Broglie-Bohm.

Cette théorie postule que les particules sont accompagnées d’une onde qui guide leur chemin, d’où le terme d’onde pilote. La particule suit toujours un chemin défini et peut être localisée. Dans le même temps, l’onde se propage à travers l’espace en explorant simultanément tous les chemins possibles. L’onde dicte alors à la particule où aller, le pilotage étant fondé sur les conditions qui prévalent le long de tous les chemins. Il y a alors deux lois, l’une pour l’onde et l’autre pour la particule et la particule sera trouvée de préférence là où l’onde est la plus intense.

Théorie des effondrements de Pearle

Il y a cependant une raison pertinente qui limite le potentiel de la théorie de l’onde pilote. Si l’onde explore différentes trajectoires alors nous vivrions dans un monde avec plein de branches vides de la fonction d’onde déconnectée de l’objet qu’elles guident. Mais David Bohm et Jeffrey Bub, dans un premier temps, puis Philip Pearle, par la suite, ont proposé une autre théorie qui offre une solution pour ce problème reposant sur l’effondrement physique. La version de Pearle incorpore un élément aléatoire qui va différer selon que l’on parle de systèmes microscopiques ou macroscopiques.

Un système microscopique, les atomes ou petits systèmes composés de quelques atomes, subira rarement des effondrements alors que pour un système macroscopique comme un corps humain ce sera plus fréquent de sorte qu’il semble que ce corps est toujours quelque part.

“La théorie de l’onde pilote et les modèles d’effondrement ont fourni des options alternatives aux physiciens quantiques qui veulent être réalistes. Les différences sont frappantes, mais les similitudes le sont aussi.

Lee Smolin, La révolution inachevée d’Einstein

La première option, croire qu’il y a à la fois des ondes et des particules, mène à la théorie de l’onde pilote. Cela permet de résoudre facilement le problème de la mesure mais cela a un prix. La théorie de l’onde pilote est doublement extravagante. Elle a une ontologie double, mais sa dynamique est asymétrique puisque la fonction d’onde guide les particules sans qu’il y ait de retour : aucune influence des particules sur l’onde. Et elle nous oblige à vivre dans un vaste monde où la fonction d’onde a de nombreuses branches vides, comme des fantômes.

Les modèles d’effondrement évitent ces objections. Il n’y a pas de double ontologie, et donc aucun problème de réciprocité. Il n’y a pas de branches vides parce qu’elles sont éliminées par les effondrements. Cela résout également le problème de la mesure, mais là aussi avec un prix à payer : des paramètres supplémentaires doivent être ajustés pour conserver la théorie à l’abri du danger.

Les deux approches s’accordent sur deux points clés : la fonction d’onde est un aspect de la réalité. Et il y a une tension avec la théorie de la relativité. Ce sont des indices vitaux pour l’avenir de la physique.“

Théorie des univers multiples d’Everett

Il y a une autre théorie réaliste, que Smolin nomme “réaliste magique”, que je vais évoquer rapidement. C’est la théorie des univers multiples formulée par Everett et qui reçut le soutien de John Wheeler et Bryce Dewitt. Ils postulent que chaque transition quantique qui a lieu dans chaque étoile, dans chaque galaxie dans le moindre coin le plus reculé de l’Univers, va scinder notre monde en une myriade de copie de lui-même. Chaque fois qu’une expérience avec différents résultats possibles est réalisée, l’Univers se scinde en autant de nouveaux mondes et chacun de nous est également scindé donnant de nouvelles versions de nous-mêmes.

Le monde dans lequel nous vivons ne constitue qu’une partie de la réalité infiniment plus vaste… réellement infiniment plus vaste. Chaque seconde, dans la pièce où vous vous trouvez actuellement, des atomes entrent en collision les uns avec les autres. Le temps que vous lisiez cette phrase, vous seriez scindés en un nombre extrêmement élevé de copies.

Ce dont nous avons besoin à ce stade, c’est de localiser, d’apporter comme preuve, quelqu’un qui a réussi d’une manière ou d’une autre – peu importe comment, vraiment – à conserver des souvenirs d’un autre présent, des impressions latentes d’un monde alternatif, différent d’une manière significative de celui-ci, celui qui est à ce stade actualisé. Selon ma vision théorique, il s’agirait presque certainement de souvenirs d’un monde pire que celui-ci. En effet, il n’est pas raisonnable que Dieu le Programmeur et Reprogrammeur substitue un monde pire en termes de liberté, de beauté, d’amour, d’ordre ou de santé – selon toute norme que nous connaissons. […] Je suis sûr qu’en m’entendant dire cela, vous ne me croyez pas vraiment, ni même que je le crois moi-même. Mais c’est pourtant vrai. Je conserve des souvenirs de cet autre monde.

Philip K Dick, Conférence de Metz, 1977

Cela demande un degré de croyance énorme pour sauver le réalisme, et c’est pour moi le problème majeur, mais pas le seul. De plus, ceci donne une vision du monde très pessimiste qui peut conduire à l’inaction. Après tout pourquoi agir et tenter de changer les choses si de toute façon toutes les possibilités existeront ? À quoi bon combattre la famine puisque cette dernière continuera d’exister dans une autre branche ? Si quel que soit le choix que je fais il existe d’autres branches avec les autres choix alors quel est l’intérêt de choisir en premier lieu ?

On comprendra cependant aisément pourquoi John Wheeler défend cette théorie car elle s’accorde avec son hypothèse du it from bit qu’il a développé et qui me semble tout à fait pertinente. Je reviendrai sur cette dernière ultérieurement.

Théorie des décohérences de Deutsch

À ce “réalisme magique”, comme l’appelle Smolin, David Deutsch et son équipe d’Oxford proposent une forme de “réalisme critique” qui repose sur ce qu’il appelle la “décohérence”. Les objets macroscopiques ne partagent pas les bizarreries qu’on observe sur les atomes dont ils sont pourtant composés. Il y aurait donc une transition séparant le monde quantique dans lequel un atome peut occuper deux positions à la fois et le monde macroscopique (ordinaire) ou un objet est toujours localisé à un seul endroit. L’idée de Deutsch est que les objets macroscopiques perdent leur “cohérence quantique”, c’est à dire leur propriété ondulatoire, d’où résulte leur comportement proche de celui de particules ordinaires. Cela exclut donc les états superposés et nous sommes toujours à un seul endroit à la fois.

Cela a le mérite d’expliquer pourquoi la physique quantique marcherait sur l’infiniment petit et la relativité générale sur l’infiniment grand. La notion d’observateur est donc conservée, mais cela reste compatible avec le réalisme car ce rôle d’observateur n’est attribué qu’aux sous-systèmes qui décohèrent. Mais alors où se situe la transition ?

Adaptation de la nouvelle de

Lovecraft en animation grâce

à l’IA

Adaptation de la nouvelle de

Lovecraft en animation

Peut-on sauver le réalisme ?

Est-il alors possible de sauver le réalisme de la mécanique quantique ? Ce qui est sûr c’est que quelle qu’en soit la version, il y a un prix à payer pour obtenir quelque chose de sensé qui décrive la nature complètement et entièrement et que ce prix est plus élevé que ce celui proposé par des solutions antiréalistes. Il semble alors dans une impasse car il n’y a pas de proposition pleinement satisfaisante pour remplacer la mécanique quantique des antiréalistes aujourd’hui. Je trouve plus élégant de me dire que nos moyens de produire la connaissance nous empêchent de capturer pleinement la réalité plutôt que de conserver le réalisme au prix d’un nombre infini d’Univers parallèles.

Mais Lee Smolin ne s’avoue pas vaincu et va tenter de construire une autre théorie fondée sur la règle 1 seulement qui n’implique pas la nécessité d’un observateur. Elle n’implique apparemment pas non plus de notion d’incertitude ou de probabilité, parce que la règle 1 est déterministe et ne fait référence à aucune probabilité.

Il propose un axe de recherche nouveau, donc “sûrement faux” comme il le dit, pour lequel il pose une série de 5 principes avant de se pencher sur les hypothèses. Ces principes sont en fait différents aspects d’un principe unique formulé par Leibniz sous le nom de raison suffisante qui dit que chaque fois qu’on identifie un aspect de l’Univers qui aurait pu être différent, un examen plus approfondi permettra de mettre au jour une raison expliquant pourquoi il en fut ainsi et pas autrement.

Il pose un changement radical, prenant le temps comme fondamental et l’espace comme émergent. Ce choix lui permet d’expliquer la non-localité quantique et l’intrication quantique. Fondamentalement, il n’y a pas d’espace. Il y a des événements, qui causent d’autres événements, donc il y a des relations causales. Ces événements constituent un réseau de relations. L’espace se présente comme une description macroscopique et approximative, granuleuse, du réseau de relations entre les événements. Dans ce cas la localité est une propriété émergente et donc la non-localité quantique résulterait des imperfections de l’émergence de l’espace.

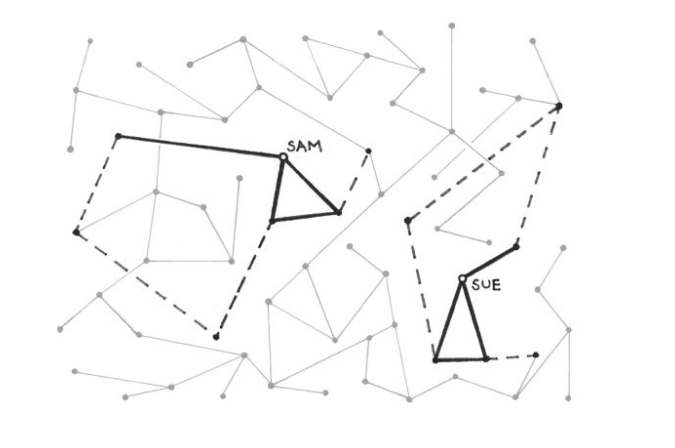

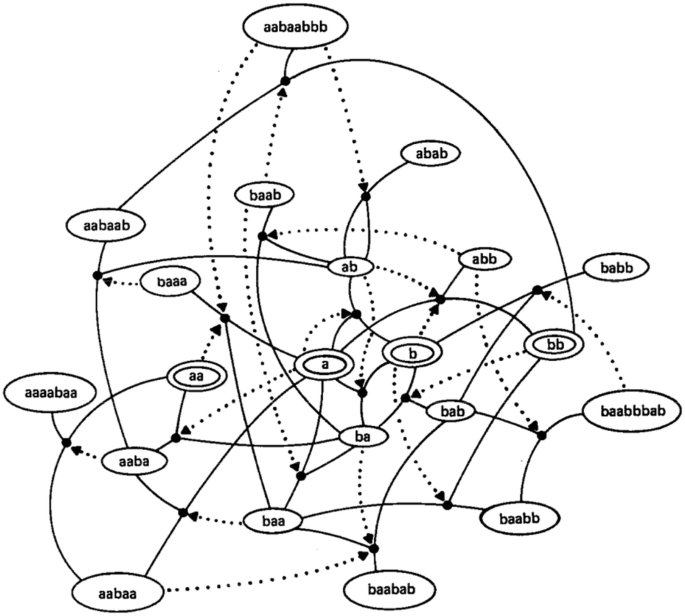

Pour ce qui est du problème d’indétermination, il reprend le principe de l’onde pilote en le transformant en une matrice. Il conserve ainsi les propriétés probabilistes de l’idée et lui retire son incompatibilité avec le principe de réciprocité dont elle souffrait initialement. Sa matrice attribue un nombre à chaque paire de particules. Il indique qu’on peut aussi représenter cela dans un graphique par des points reliés par des lignes. Chaque paire de point est relié ou non par une ligne et le nombre 1 ou 0 est attribué ou non à cette paire. On obtient ainsi un réseau pouvant expliquer l’intrication quantique puisque le lien entre deux points ne réside pas dans leur proximité géographique.

Ce que l’on tient pour l’espace émergerait alors des propriétés de ce réseau et la physique quantique résulterait des interactions non locales subsistant quand l’espace émerge.

Il reprend alors à Leibniz une autre idée qu’il va modifier qui est celle de ses monades, qu’il appelle nades afin de les différencier. Les nades ont alors deux types de propriété. Les propriétés intrinsèques qui leurs sont propres à chacune et les propriétés relationnelles qui caractérisent plusieurs nades. Un univers nadique peut alors être représenté sous la forme d’un graphique où les propriétés relationnelles sont exprimées par des étiquettes sur des liens entre des paires de nades. Chacun a alors une vision, une vue d’ensemble, qui dépend de ses connexions.

Dans son hypothèse, Leibniz ajoute que notre Univers doit se distinguer d’autres Univers en cela qu’il possède “autant de perfection que possible”, ce qui lui vaudra les railleries de Voltaire dans Candide qui représentera Leibniz par le personnage de Pangloss vivant dans “le meilleur des mondes possibles”. Mais ce que déclare ici Leibniz, si on lui retire l’allégorie du meilleur des mondes possibles, c’est qu’il existe une quantité dans notre Univers dont la valeur est supérieure à tout autre Univers possible. Donc l’Univers chercherait à maximiser une valeur que Leibniz appelle “perfection” et que Smolin appelle “action”.

Leibniz définit la perfection comme un monde ayant “le plus de variété possible” mais aussi “le plus grand ordre possible”. Smolin choisit de comprendre le mot variété comme “point de vue”. La multiplication des points de vue permet alors de mieux comprendre l’Univers mais il ne doit pas se faire au prix de l’ordre.

Smolin met en avant que les interactions physiques sont locales. Plus nous nous rapprochons, plus nos points de vue sont proches, plus s’élève la probabilité que nous interagissions par l’intermédiaire d’un échange de quanta comme les photons. Mais Smolin retourne cet argument : ce n’est pas parce que nous sommes proches physiquement que nous interagissons mais c’est parce que nos points de vue sont similaires que nous interagissons avec une probabilité élevée. La probabilité d’interagir augmente avec la similarité de nos points de vue, et diminue s’ils commencent à diverger. S’il en est ainsi, ce qui détermine fondamentalement la fréquence des interactions, c’est la similarité des points de vue, donc les liens entre les nades. Et la notion de distance dans l’espace n’en serait qu’une conséquence.

Quid de la décohérence quantique ? Pourquoi les objets macroscopiques décohèrent et pas les objets microscopiques ? Smolin attribue ce phénomène à l’unicité des objets macroscopiques. L’atome est un objet quantique parce qu’il existe beaucoup de copies presque identiques de lui, répandues à travers l’Univers, qui sont très proches de son point de vue car ils sont presque en tout point les mêmes. Et si cet atome a beaucoup de copies c’est parce qu’il est proche de la plus petite échelle possible. Un grand univers en contiendra beaucoup de copies très proches.

À l’inverse, les grands systèmes macroscopiques comme les chats, les machines ou nous-mêmes ont au contraire une grande complexité, et leur description demande une grande quantité d’informations. Même dans un très grand univers, de tels systèmes n’ont pas de copies vraiment exactes ou proches et ne font partie d’aucun ensemble. Rien n’est assez similaire à nous même pour que nous puissions interagir par le biais d’interactions non locales. Par conséquent, nous ne sommes pas soumis à l’aléatoire quantique.

Smolin en arrive enfin au principe de précédence qui va expliquer l’aspect probabiliste. Le principe de précédence va essayer de prédire l’évolution d’un système dans le temps. Pour chaque système quantique étudié aujourd’hui, il existe une collection d’états similaires dans le passé ; similaires dans le sens où ils correspondent à la même préparation, la même évolution et la même mesure que pour le système étudié. Alors le fait que les lois ne changent pas implique que les probabilités pour les résultats différents ne changent pas non plus.

La loi des précédents nous dit ceci : “Les probabilités pour les différents résultats de la présente expérience sont les mêmes que celles que nous obtiendrions en sélectionnant aléatoirement des résultats dans la collection des instances similaires antérieures”. Lee Smolin choisit de la rendre fondamentale, c’est à dire de l’énoncer comme telle comme préalable plutôt que comme une conséquence en la reformulant ainsi : “Les probabilités pour les différents résultats de l’expérience actuelle sont obtenues en choisissant aléatoirement des résultats dans la collection d’instances similaires passées.”

Son hypothèse radicale s’énonce alors de la façon suivante ” Un système physique, lorsqu’il est confronté à un choix de résultats possibles au cours d’une mesure, choisira aléatoirement un résultat parmi la collection de systèmes similaires dans le passé “. De cette manière, la plupart du temps, le présent ressemblera au passé, en ce que les probabilités des différents résultats possibles d’une même expérience seront inchangées. L’Univers étant à la fois assez grand et assez vieux pour que toute situation dans laquelle se trouve un atome (ou la plupart d’entre elles) ait de nombreux précédents, il aura appris les meilleures possibilités qui s’offrent à lui dans la majorité des situations.

Je trouve cette piste élégante car elle se marie bien avec ce que j’ai présenté au préalable sur la façon de concevoir la vie. L’Univers va chercher à maximiser une valeur, et je crois personnellement que ce n’est pas la variété des points de vue qui n’est sûrement qu’un proxy pour la dissipation d’énergie car la variété des points de vue sera autant d’information sur le système qui va permettre d’augmenter la néguentropie du sous-système local et l’entropie générale de l’Univers. Ces nades auront un point de vue d’autant plus proche qu’elles partagent de l’information et pour les humains ce sera l’information contenue dans nos gènes et nos idées qui vont former notre vision du monde. L’augmentation des différents points de vue va alors nécessairement augmenter l’ordre dans l’Univers puisqu’il va augmenter l’information dont on dispose sur le système, l’Univers.

Cette perspective me plait assez car tout cela est parfaitement en accord avec ce que j’ai énoncé dans les articles précédents sur la thermodynamique et l’évolution. Mieux encore, son idée de réseau ressemble incroyablement à ce que propose Stuart Kaufmann comme apparition de la vie via des processus chimiques autocatalytiques comme on l’a vu précédemment.

On pourrait alors imaginer une réplication fractale du même type de phénomène partant de l’univers et créant les nouvelles structures dissipatives au fur et à mesure selon les mêmes lois avec une alternance entre évolution macro et évolution micro.

Mais je ne pense pas que Smolin goûte trop à l’idée de l’information comme propriété fondamentale du cosmos. Elle semblerait pourtant logique et c’est d’autant plus étrange que Leibniz, à qui il reprend de nombreuses idées, est aussi l’inventeur du bit. Aucune de ses idées même n’a été plus importante que l’invention du système de nombres binaires, sur lequel sont basés tous les ordinateurs modernes. Mais je crois que si Smolin est réticent à reprendre cette idée, c’est tout simplement par peur de tomber dans l’antiréalisme ou donner du crédit à cette vision formulée par John Wheeler, qu’il a nommé l’hypothèse du it from bit.

“Son tableau noir différait de tous ceux que j’ai pu rencontrer : pas d’équations, seulement quelques aphorismes élégamment écrits, chacun présenté dans un cadre, distillant une vie entièrement consacrée à chercher la raison pour laquelle notre monde est quantique. Un exemple typique était « It from bit ». Wheeler fut l’un des premiers à suggérer de considérer le monde comme étant constitué d’information, et l’information comme plus fondamentale que ce qu’elle décrit. Une forme d’antiréalisme, très à la mode en ce moment sur lequel nous reviendrons.”

Lee Smolin, La révolution inachevée d’Einstein

Afin d’étudier plus en détails ce qu’est l’hypothèse du it from bit il nous faut comprendre ce que l’on entend ici par information.

Le Moment

Straussien

Ebook offert à nos tipeurs

sans montant minimum

Le Moment

Straussien

Ebook offert à nos tipeurs

sans montant minimum

Qu’est-ce que l’information

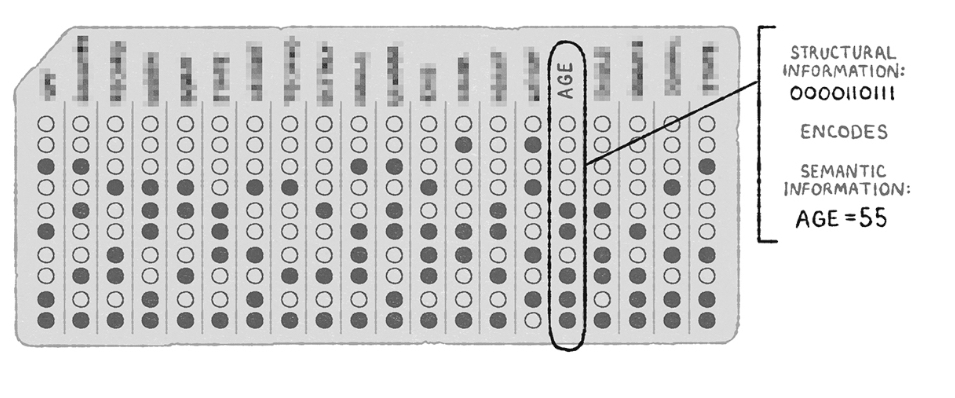

Qu’appelle-t-on information, ici présent ? Dans la théorie de l’information, qui a été inventée en 1948 par le mathématicien Claude Shannon, l’information est comprise en tant que quantité, des bits, mais les données sont aussi sémantiques en cela qu’elles impliquent des faits. Le type d’information le plus intéressant apparaît lorsque les bits codent des faits, ou lorsque l’information structurelle code des informations sémantiques. C’est ce que David Chalmers appelle l’information symbolique. Par exemple, la séquence de bits 110111 (information structurelle) dans une certaine zone de la mémoire d’une base de données – ou sur une carte perforée – peut encoder le fait que votre âge est de vingt-cinq ans (information sémantique).

L’information symbolique est le type d’information utilisé par la science moderne des données. Nos bases de données, nos systèmes informatiques transportent des informations sur le monde, et les bits codent des faits. Mais cette information symbolique est également présente dans notre langage. Une chaîne de lettres, comme “Vous lisez mon article”, encode un fait sur le monde. Le langage dans son ensemble implique des informations symboliques.

“Les messages eux-mêmes forment un motif, une organisation. En effet, il est possible de considérer les séries de messages comme ayant une entropie à l’égard des séries d’états du monde extérieur. De même que l’entropie est une mesure de désorganisation, l’information fournie par une série de messages est une mesure d’organisation. En fait, il est possible d’interpréter l’information fournie par un message comme étant essentiellement la valeur négative de son entropie, et le logarithme négatif de sa probabilité. C’est-à-dire, plus le message est probable, moins il fournit d’information. Les clichés ou les lieux communs, par exemple, éclairent moins que les grands poèmes.”

Norbert Wiener, Cybernétique et société

L’hypothèse du it from bit

Wheeler était ce type de personne un peu engoncé, toujours le dernier bouton de la chemise boutonné, jamais un mot plus haut que l’autre mais il est aussi celui qui avait les idées les plus folles.

Parmi lesquelles beaucoup d’idées surtout fausses, comme la fois où il a postulé qu’il n’y avait qu’un électron dans l’univers, des idées intrigantes comme celle du positron qui serait un électron voyageant dans le temps en sens inverse mais Il fut aussi l’un des premiers physiciens éminents à proposer que la réalité ne soit pas entièrement physique ; en un sens, notre cosmos doit être un phénomène “participatif” nécessitant l’acte d’observation. Ce qui en fait une théorie antiréaliste selon Smolin puisque cela confère un rôle particulier à la mesure. La soudaineté de l’effondrement de la fonction d’onde lors de la mesure, dictée par la règle 2, signifie que les états quantiques changent d’une manière qui ne tient pas compte de la localité ni de l’énergie, et qui semble dépendre directement de ce que nous savons ou croyons.

Mais Wheeler a surtout attiré l’attention sur les liens intrigants entre la physique et la théorie de l’information de Claude Shannon. Tout comme la physique s’appuie sur une entité élémentaire, le quantum, défini par l’acte d’observation, la théorie de l’information fait de même. Son “quantum” est l’unité binaire, ou bit, qui est un message représentant l’un des deux choix suivants : pile ou face, oui ou non, zéro ou un.

Wheeler postule alors que “chaque chose – chaque particule, chaque champ de force, voire le continuum espace-temps lui-même – tire sa fonction, sa signification, son existence même entièrement – même si, dans certains contextes, c’est de manière indirecte – des réponses données par l’appareil de mesure aux questions oui ou non, aux choix binaires, aux bits.

Cette formule symbolise l’idée que chaque élément du monde physique a, au fond, une source et une explication immatérielles ; que ce que nous appelons réalité découle en dernière analyse de la formulation de questions binaires et de l’enregistrement de réponses provoquées par un équipement ; en bref, que toutes les choses physiques sont d’origine informationnelle et qu’il s’agit d’un univers participatif impliquant la conscience de l’observateur.

“La politique de l’inventeur du moteur, John Kris, nous dit : “Mettez-le en marche et voyez pourquoi il ne part pas !”. Dans cet esprit, je tente, comme d’autres chercheurs, de formuler les questions centrales les unes après les autres, et je présente ici une vue d’ensemble plus large, en prenant pour hypothèse de travail la plus efficace qui a survécu à ce vannage : Le “it” à partir du “bit”. Autrement dit, chaque “it” – chaque particule, chaque champ de force, voire le continuum espace-temps lui-même – tire sa fonction, sa signification, son existence même, entièrement – même si, dans certains contextes, c’est de manière indirecte – des réponses obtenues par l’appareil à des questions oui ou non, des choix binaires, des bits.”

John Wheeler, “Information, Physics, Quantum: The Search for Links.”

Se pourrait-il qu’il existe un “monde de l’information” qui ne soit pas régit par les lois de la physique ? Un monde dualiste avec l’information d’un côté et la représentation de l’autre ne me surprendrait pas et ça ne remettrait pas en cause l’existence d’une réalité objective existant sans observateur et peut-être même pas notre capacité à la connaître pleinement. Alors Platon aurait raison depuis le début avec son monde des idées ? C’est ce que pense Roger Penrose en tout cas qui imagine que “chaque fois que l’esprit perçoit une idée mathématique, il prend contact avec le monde platonicien des idées”.

Vivons nous dans une simulation ?

L’hypothèse du it from bit mène naturellement à l’idée que nous vivions dans une simulation où toute chose dans son essence est constituée de bits, ou peut-être même de trits ou, comme David Deutsch l’a exploré, de qbits. Mais cette vision des choses peut se marier avec une certaine forme de réalisme car dans tous ces cas, la nature existerait indépendamment de nous et on pourrait en comprendre les rouages et prédire les actions puisque cela reviendrait à déchiffrer l’algorithme qui la sous-tend. C’est une position que défend David Chalmers dans son ouvrage Reality + où il donne 5 critères prévalents pour définir si nous vivons dans la réalité. Afin de décider si le monde qui nous entoure est la réalité, nous devons pouvoir répondre oui à ces 5 questions :

Est-ce que les objets qu’on perçoit dans cette simulation sont réels ? Oui, l’arbre que je vois existe réellement. À un certain niveau, c’est un objet numérique, ancré dans des processus numériques dans un ordinateur, mais il n’est pas moins réel pour autant.

Les objets que nous percevons ont-ils un pouvoir de causalité ? Oui, l’arbre produit des feuilles, il accueille des oiseaux (qui sont aussi des objets numériques) et il fait naître des expériences chez ceux qui le regardent.

Est-ce que ces objets sont indépendants de notre esprit ? Oui, l’arbre est un objet numérique, fait de bits, qui ne dépend pas de l’existence d’observateur pour exister.

Les objets sont-ils tels qu’ils semblent être ? Oui, ce sont des vraies fleurs qui fleurissent et je viens de France. Ce sont des objets numériques mais les fleurs fleurissent bien et je suis bien de France.

Est-ce que les objets dont je fais l’expérience sont des vraies fleurs, vrais livres, vraies personnes… ? Oui, si j’ai vécu dans cette simulation toute ma vie, tout cela est réel car c’est la réalité à laquelle j’appartiens.

“Si l’hypothèse du it-from-bit est correcte, il y a toujours des quarks, des chats et des chaises. C’est juste que les chats et les chaises sont faits d’atomes qui sont faits de quarks qui sont faits de bits.”

David Chalmers, Reality +

En cela, l’hypothèse de la simulation pourrait être réaliste mais pas de façon naïve comme le souhaiterait Lee Smolin. Autre corolaire, si nous vivons dans une simulation, alors qui a créé cette dernière ?

Dieu est-il un hacker ?

“Je me suis toujours considéré comme athée, aussi loin que je me souvienne. Ma famille n’était pas religieuse, et les rituels religieux m’ont toujours semblé un peu désuets. Je ne voyais pas beaucoup de preuves de l’existence d’un dieu. Dieu semblait surnaturel, alors que j’étais attiré par le monde naturel de la science. Pourtant, l’hypothèse de la simulation m’a fait prendre l’existence d’un dieu plus au sérieux que je ne l’avais jamais fait auparavant.”

David Chalmers, Reality +

Si nous vivons dans une simulation alors cette simulation fut nécessairement générée par un démiurge. Pas un Dieu qui règne sur tout le cosmos mais un démiurge qui a créé le programme, qui l’a lancé et qui a le contrôle dessus. Un créateur, tout puissant, omniscient, que David Chalmers va jusqu’à qualifier de “bon”mais je ne vois pas nécessairement ce qui le permet. Ce démiurge ne m’apparaitrait plutôt ni bienveillant ni malveillant.

Mais alors Platon pourrait aussi avoir raison avec son idée de démiurge. Il y aurait même d’une certaine façon une migration des âmes en tant que transfert d’information. Et si on vit dans une simulation alors elle est constituée d’algorithmes qui pourrait être autant de Dieux.

Alors on pourrait réconcilier les chrétiens et les païens avec un Dieu unique en dehors de la création et des Dieux qui interviennent directement dans le monde “réel”. Et s’il y avait effectivement un démiurge tout puissant il pourrait faire flamber un buisson sans qu’il brûle simplement pour se marrer en observant la réaction du pauvre bougre à qui il joue ce tour… Et c’est ce qui me dérange un peu dans cette idée. On pourrait être prêt à croire un peu n’importe quoi. Et je crois que nous devons être vigilant avec cela. Même si notre capacité à comprendre le monde qui nous entoure était limitée, je crois comme David Chalmers que la réalité existe, que la vérité compte et “qu’il existe des vérités sur la réalité”.

“Le plus important : La réalité existe, indépendamment de nous. La vérité compte. Il y a des vérités sur la réalité, et nous pouvons essayer de les trouver. Même à l’ère des réalités multiples, je crois toujours à la réalité objective.”

David Chalmers, Reality +

En tous les cas, ni Platon ni le Christ n’auraient pour autant raison de dévaloriser le corps et l’action au profit du seul intellect et de la pensée. C’est pourquoi, quoi qu’il arrive, la morale reposant sur la philosophie d’Aristote et l’art d’Archiloque que j’ai présenté reste valable avec ou sans démiurge et dans une vision moniste ou dualiste des choses. Elle permet la disposition nécessaire pour tenter de cracker le code de la création et peut-être se rendre compte que Platon avait raison mais, ironiquement, adopter un mode de vie platonicien ne permettrait pas de le découvrir. Il fallait donc que l’Occident se déchristianise pour qu’on puisse reposer la question de Dieu sur de bonnes bases, mais n’en voulons pas au Christianisme pour autant, de la même façon qu’on ne peut en vouloir à Épiméthée de sa faute. Apprendre c’est nécessairement agir, faire des erreurs et réviser son jugement.

Vous comprenez mieux pourquoi je disais dans le premier article qu’entre Athènes et Jérusalem, je choisis Athènes pour sa raison, mais aussi pour ses questionnements métaphysiques. Les présocratiques sont des matérialistes, Platon est un idéaliste et Aristote apporte une bonne synthèse des deux.

Les Lumières ont choisi de mettre ces questions de côté, mais ce sont ces mêmes Lumières qui ont conduit aujourd’hui à les remettre sur la table. Il faut bien comprendre que se poser ces questions n’est pas se positionner contre les Lumières mais s’inscrire dans leur prolongement car ce sont elles qui font légitimement revenir ces questions, lavées de la fausseté qu’elles comportaient.

L’information est physique ?

Quel est donc le problème de dire que tout se résume à des informations, des bits, des réponses à nos questions ? Tout d’abord, comme aimait à le dire le physicien Rolf Landauer, toute information est physique – c’est-à-dire que toute information est incarnée dans des choses ou des processus physiques – mais cela ne signifie pas que toutes les choses physiques seraient nécessairement réductibles à l’information. Le concept d’information n’a aucun sens en l’absence de quelque chose à informer, c’est-à-dire d’un observateur conscient capable de choix. Si tous les humains du monde disparaissaient demain, toutes les informations disparaîtraient également. Sans esprit de surprise et de changement, les livres, les télévisions et les ordinateurs seraient aussi stupides que des souches et des pierres car l’aspect sémantique de l’information est aussi important que son aspect structurel.

Melvin Volpson, physicien à l’université de Portsmouth, pense, lui, que l’information pourrait être le cinquième état de la matière en s’appuyant sur les travaux de Rold Landauer. Volpson va plus loin en attribuant une masse à l’information et émet l’hypothèse que ce que nous appelons “matière noire” ne serait en fait rien d’autre que cette information.

“Comme il y a un nombre incroyablement grand de particules élémentaires composant l’Univers, alors l’univers visible contiendrait également une énorme quantité de bits numériques associés au contenu informationnel de ces particules. Le principe de Landauer a démontré que l’information est physique. Le principe d’équivalence masse-énergie-information a extrapolé cela et a démontré que l’information a en fait une masse. Puisqu’il y a beaucoup d’informations associées à la masse baryonique dans l’Univers, alors ce doit être une énorme quantité de masse qui correspond à cette information.”

Melvin Volpson

Si tel était le cas, alors je serais on ne peut plus matérialiste et réaliste puisque l’information ferait entièrement partie du monde physique mais encore une fois, cela relève purement de la croyance à ce stade et que l’on choisisse l’un ou l’autre cas n’a pas beaucoup d’importance. Même s’il y avait un démiurge, vous n’avez pas besoin de vous pencher sur un tapis 5 fois par jours et même si les objets sont faits de bits et non de matière ils n’en sont pas moins réels pour vous. Mais il n’en reste pas moins que s’affirmer réaliste repose autant sur une forme de foi que de penser que le monde fut créé par Dieu – sous réserve de ce que vous nommez Dieu, bien sûr.

L’univers apprenant

Vous l’aurez compris, ce qui m’intéresse dans la version de Smolin, celle de Wheeler ou encore la simulation de Chalmers c’est leur compatibilité avec la thermodynamique, l’évolution, la théorie de l’information de Claude Shannon et la cybernétique de Norbert Wiener. L’une comme l’autre permet de dresser les contours d’un Univers apprenant qui pourrait donner toute son importance à l’information dès lors qu’il existe une valeur à maximiser.

“Fondamentale, en cybernétique, est l’identification de la nature de l’information – qui est le logarithme négatif d’une probabilité – au négatif de l’entropie. Cette relation n’est pas simplement formelle, puisque, comme l’a montré Szilard, le démon de Maxwell nous donne un moyen de transformer l’information en perte d’entropie.”

Norbert Wiener, La cybernétique

Comme le note François Roddier, dans son ouvrage Thermodynamique de l’évolution, la notion d’entropie relève elle aussi de nos connaissances et de notre observation. C’est l’information dont on dispose sur un système qui permet de réduire l’entropie. Comme pour la mécanique quantique, l’aspect informationnel de l’entropie nous amène à un problème fondamental sur la nature de nos connaissances. Mieux comprendre l’Univers c’est mieux comprendre l’homme et mieux comprendre l’homme c’est mieux comprendre l’Univers. On ne peut comprendre l’un sans l’autre car l’homme est un produit de l’évolution de l’Univers.

Plus encore, la progression de nos connaissances est elle-même la conséquence des lois de l’évolution de l’Univers. On peut rapprocher cela d’un papier de Stephon Alexander et Lee Smolin arguant que l’Univers est organisé de la même façon qu’un système apprenant. Nous vivons dans un Univers probabiliste et non déterministe. De là à penser que l’Homme apprenant est intimement lié à l’Univers apprenant il n’y a qu’un pas. En cela, nous sommes condamnés à accepter de faire reposer notre vision du monde sur une part de croyance qui est appelée à être révisée et suspendre notre jugement si nécessaire.

Une partie de moi aimerait croire que la conscience n’est pas un sous-produit accidentel du monde physique, mais qu’elle est en quelque sorte le but premier de la réalité. Sans nous pour y réfléchir, l’univers n’a aucun sens ; pire, il est ennuyeux. Mais la partie la plus dure de mon esprit voit des idées comme le it from bit comme une forme de mysticisme flou que la science est censée nous aider à surmonter.

Vous comprenez alors pourquoi je n’ai pas mis cet article dans la série d’articles principale car je n’ai pas d’idées arrêtées dessus sur lesquelles faire reposer ma vision du monde. Je peux seulement y intégrer mon questionnement sur ces problèmes.

Dans le prochain article, nous nous pencherons sur la conscience.

Cet article vous a plus ? Soutenez nous sur Tipeee

Très bon article, belle synthèse.

Cependant, j’ai quelques idées divergentes 🙂

– en premier lieu, le problème de la mesure. Qu’est-ce qu’une mesure au juste ? il semble que presque tout le monde parte du principe que seules les expériences en labos sur des particules sont des mesures. Mais ou est la mesure EXACTEMENT ? sur l’écran ? sur la fente ? sur le miroir ? dans l’oeil du physicien ?

En fait c’est une interaction, et tout est en interaction finalement. La décohérence à lieu tout le temps car les particules isolées qu’on fabrique pour les expériences n’existent “presque” pas dans la nature. Il n’y a pas que le physicien qui “mesure” la réalité, elle se mesure elle même en permanence, elle le fait très bien sans nous et même sans la vie.

– le problème des constantes cosmologiques et celui de l’émanence. Comme vous le savez nous avons un soucis pour expliquer le “fine tuning” des constantes de l’univers. Le moindre changement dans l’une des nombreuses constantes et l’univers s’effondre. Hors … il existe une théorie pour expliquer ce “fine tuning” : le monde macro influence le monde micro (c’est le principe de l’émanence). On ne sait pas exactement comment, mais ça aurait été confirmé par certains calculs sur les trous noirs … je n’ai pas le niveau pour piger ces calculs. Mais bon bref, ça expliquerait donc pourquoi le monde macro reste cohérent malgré le bordel au niveau de la mousse quantique, parce que les probabilités sont “influencées” par le macro.

– la théorie de l’onde pilote à reçut une attention accrue depuis les expériences d’Yves Couder sur les gouttes marcheuses, dans lesquelles ce professeur à réussit à reproduire au niveau macro des phénomènes quantiques tels que les fentes de young en version onde/particule et d’autres. Fascinant.

– la “raison suffisante” que vous évoquez, selon moi elle existe, c’est l’équation “delta S = 0”, c’est le principe de moindre action, la loi fondamentale (et entropique) connue de l’univers qui unifie toutes les équations connues actuellement (on peut reformuler toutes les équations sous la forme deltaS = 0)

– le problème de la non localité c’est que ça brise la vitesse de la lumière, et que ça n’a jamais été pris en défaut jusqu’ici

Tout ceci étant dit, je saute directement à ma conclusion personnelle sur ces questions : on ne peut (au mieux) que se rapprocher tangentiellement de la réalité. Elle existe mais est inconnaissable dans l’absolu. Le réel c’est la version “très appauvrie” de la réalité que nos sens en perçoivent. Quand je dis “très appauvrit” je parle de 0.0001% de la réalité peut être (dans notre sphère immédiate évidement, sinon à l’échelle de l’univers ça serait 10 exposant – 10 exposant je ne sais combien de milliers … lol)

Encore un commentaire de grande qualité de votre part. Merci!