Est-il possible de sauver le réalisme de la mécanique quantique ? Ce qui est sûr, c’est que quelle qu’en soit la version, il y a un prix à payer pour obtenir quelque chose de sensé qui décrive la nature complètement et entièrement et que ce prix est plus élevé que ce celui proposé par des solutions antiréalistes. Il semble alors que nous soyons dans une impasse car il n’y a pas de proposition pleinement satisfaisante pour remplacer la mécanique quantique des antiréalistes aujourd’hui. Je trouve plus élégant de me dire que nos moyens de produire la connaissance nous empêchent de capturer pleinement la réalité plutôt que de conserver le réalisme au prix d’un nombre infini d’Univers parallèles.

Mais Lee Smolin ne s’avoue pas vaincu et va tenter de construire une autre théorie fondée sur la règle 1 seulement qui n’implique pas la nécessité d’un observateur. Elle n’implique apparemment pas non plus de notion d’incertitude ou de probabilité, parce que la règle 1 est déterministe et ne fait référence à aucune probabilité.

Il propose un axe de recherche nouveau, donc « sûrement faux » comme il le dit, pour lequel il pose une série de 5 principes avant de se pencher sur les hypothèses. Ces principes sont en fait différents aspects d’un principe unique formulé par Leibniz sous le nom de raison suffisante qui dit que chaque fois qu’on identifie un aspect de l’Univers qui aurait pu être différent, un examen plus approfondi permettra de mettre au jour une raison expliquant pourquoi il en fut ainsi et pas autrement.

Il pose un changement radical, prenant le temps comme fondamental et l’espace comme émergent. Ce choix lui permet d’expliquer la non-localité quantique et l’intrication quantique. Fondamentalement, il n’y a pas d’espace. Il y a des événements, qui causent d’autres événements, donc il y a des relations causales. Ces événements constituent un réseau de relations. L’espace se présente comme une description macroscopique et approximative, granuleuse, du réseau de relations entre les événements. Dans ce cas la localité est une propriété émergente et donc la non-localité quantique résulterait des imperfections de l’émergence de l’espace.

Traité

Néoréactionnaire

Le premier livre de NIMH

Traité

Néoréactionnaire

Le premier livre de NIMH

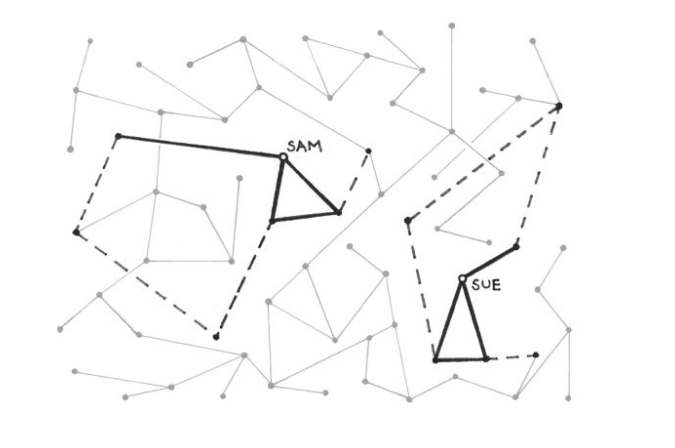

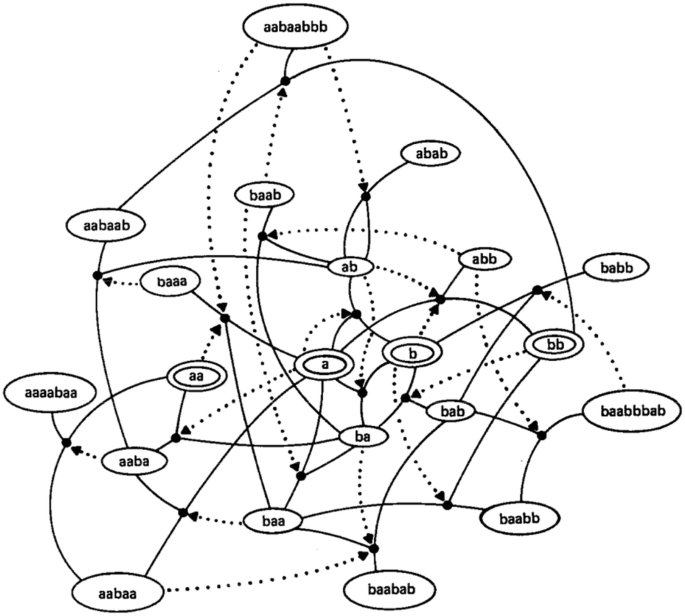

Pour ce qui est du problème d’indétermination, il reprend le principe de l’onde pilote en le transformant en une matrice. Il conserve ainsi les propriétés probabilistes de l’idée et lui retire son incompatibilité avec le principe de réciprocité dont elle souffrait initialement. Sa matrice attribue un nombre à chaque paire de particules. Il indique qu’on peut aussi représenter cela dans un graphique par des points reliés par des lignes. Chaque paire de point est reliée ou non par une ligne et le nombre 1 ou 0 est attribué ou non à cette paire. On obtient ainsi un réseau pouvant expliquer l’intrication quantique puisque le lien entre deux points ne réside pas dans leur proximité géographique.

Ce que l’on tient pour l’espace émergerait alors des propriétés de ce réseau et la physique quantique résulterait des interactions non locales subsistant quand l’espace émerge.

Il reprend alors à Leibniz une autre idée qu’il va modifier qui est celle de ses monades, qu’il appelle nades afin de les différencier. Les nades ont alors deux types de propriété. Les propriétés intrinsèques qui leur sont propres à chacune et les propriétés relationnelles qui caractérisent plusieurs nades. Un univers nadique peut alors être représenté sous la forme d’un graphique où les propriétés relationnelles sont exprimées par des étiquettes sur des liens entre des paires de nades. Chacun a alors une vision, une vue d’ensemble, qui dépend de ses connexions.

Dans son hypothèse, Leibniz ajoute que notre Univers doit se distinguer d’autres Univers en cela qu’il possède « autant de perfection que possible », ce qui lui vaudra les railleries de Voltaire dans Candide qui représentera Leibniz par le personnage de Pangloss vivant dans « le meilleur des mondes possibles ». Mais ce que déclare ici Leibniz, si on lui retire l’allégorie du meilleur des mondes possibles, c’est qu’il existe une quantité dans notre Univers dont la valeur est supérieure à tout autre Univers possible. Donc l’Univers chercherait à maximiser une valeur que Leibniz appelle « perfection » et que Smolin appelle « action ».

Leibniz définit la perfection comme un monde ayant « le plus de variété possible » mais aussi « le plus grand ordre possible ». Smolin choisit de comprendre le mot variété comme « point de vue ». La multiplication des points de vue permet alors de mieux comprendre l’Univers mais il ne doit pas se faire au prix de l’ordre.

Smolin met en avant que les interactions physiques sont locales. Plus nous nous rapprochons, plus nos points de vue sont proches, plus s’élève la probabilité que nous interagissions par l’intermédiaire d’un échange de quanta comme les photons. Mais Smolin retourne cet argument : ce n’est pas parce que nous sommes proches physiquement que nous interagissons, mais c’est parce que nos points de vue sont similaires que nous interagissons avec une probabilité élevée. La probabilité d’interagir augmente avec la similarité de nos points de vue, et diminue s’ils commencent à diverger. S’il en est ainsi, ce qui détermine fondamentalement la fréquence des interactions, c’est la similarité des points de vue, donc les liens entre les nades. Et la notion de distance dans l’espace n’en serait qu’une conséquence.

Quid de la décohérence quantique ? Pourquoi les objets macroscopiques décohèrent et pas les objets microscopiques ? Smolin attribue ce phénomène à l’unicité des objets macroscopiques. L’atome est un objet quantique parce qu’il existe beaucoup de copies presque identiques de lui, répandues à travers l’Univers, qui sont très proches de son point de vue car ils sont presque en tout point les mêmes. Et si cet atome a beaucoup de copies c’est parce qu’il est proche de la plus petite échelle possible. Un grand univers en contiendra beaucoup de copies très proches.

À l’inverse, les grands systèmes macroscopiques comme les chats, les machines ou nous-mêmes ont au contraire une grande complexité, et leur description demande une grande quantité d’informations. Même dans un très grand univers, de tels systèmes n’ont pas de copies vraiment exactes ou proches et ne font partie d’aucun ensemble. Rien n’est assez similaire à nous même pour que nous puissions interagir par le biais d’interactions non locales. Par conséquent, nous ne sommes pas soumis à l’aléatoire quantique.

Smolin en arrive enfin au principe de précédence qui va expliquer l’aspect probabiliste. Le principe de précédence va essayer de prédire l’évolution d’un système dans le temps. Pour chaque système quantique étudié aujourd’hui, il existe une collection d’états similaires dans le passé ; similaires dans le sens où ils correspondent à la même préparation, la même évolution et la même mesure que pour le système étudié. Alors le fait que les lois ne changent pas implique que les probabilités pour les résultats différents ne changent pas non plus.

La loi des précédents nous dit ceci : « Les probabilités pour les différents résultats de la présente expérience sont les mêmes que celles que nous obtiendrions en sélectionnant aléatoirement des résultats dans la collection des instances similaires antérieures ». Lee Smolin choisit de la rendre fondamentale, c’est à dire de l’énoncer comme telle comme préalable plutôt que comme une conséquence en la reformulant ainsi : « Les probabilités pour les différents résultats de l’expérience actuelle sont obtenues en choisissant aléatoirement des résultats dans la collection d’instances similaires passées .»

Son hypothèse radicale s’énonce alors de la façon suivante : « Un système physique, lorsqu’il est confronté à un choix de résultats possibles au cours d’une mesure, choisira aléatoirement un résultat parmi la collection de systèmes similaires dans le passé ». De cette manière, la plupart du temps, le présent ressemblera au passé, en ce que les probabilités des différents résultats possibles d’une même expérience seront inchangées. L’Univers étant à la fois assez grand et assez vieux pour que toute situation dans laquelle se trouve un atome (ou la plupart d’entre elles) ait de nombreux précédents, il aura appris les meilleures possibilités qui s’offrent à lui dans la majorité des situations.

Je trouve cette piste élégante car elle se marie bien avec ce que j’ai présenté au préalable sur la façon de concevoir la vie. L’Univers va chercher à maximiser une valeur, et je crois personnellement que ce n’est pas la variété des points de vue. Il s’agit sûrement qu’un proxy, car la variété des points de vue sera autant d’information sur le système qui va permettre d’augmenter la néguentropie du sous-système local et l’entropie générale de l’Univers. Ces nades auront un point de vue d’autant plus proche qu’elles partagent de l’information et pour les humains ce sera l’information contenue dans nos gènes et nos idées qui vont former notre vision du monde. L’augmentation des différents points de vue va alors nécessairement augmenter l’ordre dans l’Univers puisqu’il va augmenter l’information dont on dispose sur le système, l’Univers.

Cette perspective me plaît assez car tout cela est parfaitement en accord avec ce que j’ai énoncé dans les articles précédents sur la thermodynamique et l’évolution. Mieux encore, son idée de réseau ressemble incroyablement à ce que propose Stuart Kaufmann comme apparition de la vie via des processus chimiques autocatalytiques comme on l’a vu précédemment.

Horreur

Augmentée

Sélection de textes de

Zero HP Lovecraft

Horreur

Augmentée

Sélection de textes de

Zero HP Lovecraft

On pourrait alors imaginer une réplication fractale du même type de phénomène partant de l’univers et créant les nouvelles structures dissipatives au fur et à mesure selon les mêmes lois avec une alternance entre évolution macro et évolution micro.

Lorsque — pour prendre un exemple opposé — Leibniz veut établir sa monadologie, il raisonne, en résumé, comme ceci : Tout ce qui est complexe doit être composé de parties simples ; or, ce qui est simple ne peut être étendu, par conséquent tout est composé de parties sans étendue. Mais ce qui n’est pas étendu n’est pas matière ; par conséquent ce qui constitue, en dernier lieu, les objets, n’est pas matériel et si ce n’est pas matériel, il faut donc que ce soit mental. Par conséquent, une table est réellement une colonie d’âmes.

Bertrand Russell, Histoire de la philosophie occidentale

Tout dans la vision de Leibniz, en dernier lieu, les choses mondaines ne sont pas matérielles. Exactement comme le pense John Wheeler avec le it from bit. Mais je ne pense pas que Smolin goûte trop à l’idée de l’information comme propriété fondamentale du cosmos. Elle semblerait pourtant logique et c’est d’autant plus étrange que Leibniz, à qui il reprend de nombreuses idées, est aussi l’inventeur du bit. Aucune de ses idées même n’a été plus importante que l’invention du système de nombres binaires, sur lequel sont basés tous les ordinateurs modernes. Mais je crois que si Smolin est réticent à reprendre cette idée, c’est tout simplement par peur de tomber dans l’antiréalisme ou donner du crédit à cette vision formulée par John Wheeler, qu’il a nommé l’hypothèse du it from bit.

Son tableau noir différait de tous ceux que j’ai pu rencontrer : pas d’équations, seulement quelques aphorismes élégamment écrits, chacun présenté dans un cadre, distillant une vie entièrement consacrée à chercher la raison pour laquelle notre monde est quantique. Un exemple typique était « It from bit ». Wheeler fut l’un des premiers à suggérer de considérer le monde comme étant constitué d’information, et l’information comme plus fondamentale que ce qu’elle décrit. Une forme d’antiréalisme, très à la mode en ce moment sur lequel nous reviendrons.

Lee Smolin, La révolution inachevée d’Einstein